深度學習框架在計算機視覺應用背后的挑戰 軟硬件協同開發的新命題

計算機視覺作為人工智能領域的核心分支,已廣泛應用于安防監控、自動駕駛、醫療影像、工業質檢等眾多場景。這些應用的蓬勃發展,極大地推動了深度學習技術的進步,同時也對支撐其運行的深度學習框架提出了前所未有的挑戰。這些挑戰不僅體現在算法模型本身,更深刻地映射到計算機軟件與硬件的協同開發與優化上。

一、 軟件層面的核心挑戰

- 模型復雜性與框架靈活性:現代計算機視覺模型(如Transformer、大型卷積神經網絡)結構日益復雜,參數量巨大。深度學習框架需要提供高度靈活且高效的編程接口與計算圖構建能力,以支持研究人員快速設計、實驗和部署新模型,同時確保前向推理與反向傳播的計算正確性與效率。

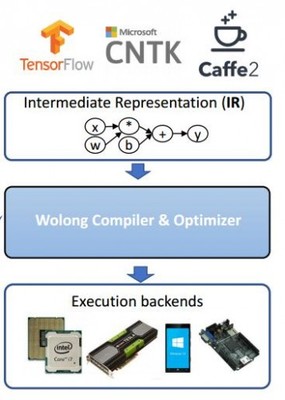

- 計算效率與優化編譯:視覺任務通常涉及高分辨率圖像或視頻流,計算密集度高。框架需要集成先進的圖優化、算子融合、內存復用等技術,并具備強大的即時(JIT)編譯或提前(AOT)編譯能力,將高級模型描述轉化為底層硬件高效執行的指令,以最大化利用計算資源。

- 部署的多樣性與易用性:從云端服務器到邊緣設備(如手機、攝像頭、車載芯片),視覺模型的部署環境差異巨大。框架需提供統一的模型表示(如ONNX),并支持跨平臺、跨硬件的模型轉換、量化和壓縮工具鏈,以降低從訓練到部署的工程門檻。

- 動態性與實時性需求:許多視覺應用(如自動駕駛感知、實時視頻分析)要求低延遲和高吞吐量。框架需要高效處理動態輸入(如可變尺寸圖像)、支持流式處理,并能在嚴格的時間約束下完成計算。

二、 硬件層面的驅動與約束

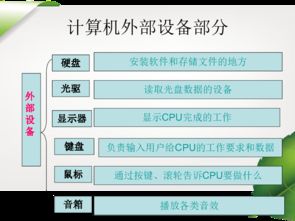

- 硬件架構的多元化:除了傳統的CPU,深度學習計算已廣泛依賴于GPU、NPU、TPU、FPGA等多種專用加速器。每種硬件都有其獨特的計算單元、內存層次和指令集。深度學習框架必須能夠抽象底層硬件差異,提供統一的編程模型,同時又能針對特定硬件進行深度優化,發揮其峰值算力。

- 內存與帶寬瓶頸:視覺模型參數量大,中間激活值也占用海量內存。硬件的內存容量和帶寬常常成為性能瓶頸。框架的優化器需要精打細算地進行內存分配與調度,利用硬件特性(如GPU的共享內存、高速緩存)來減少數據搬運開銷。

- 能效比要求:特別是在移動端和邊緣端,硬件算力和電池容量有限。框架需要與硬件緊密結合,支持模型剪枝、量化(如INT8、FP16)、知識蒸餾等技術,在保證一定精度的前提下,大幅降低模型的計算量與存儲需求,提升能效比。

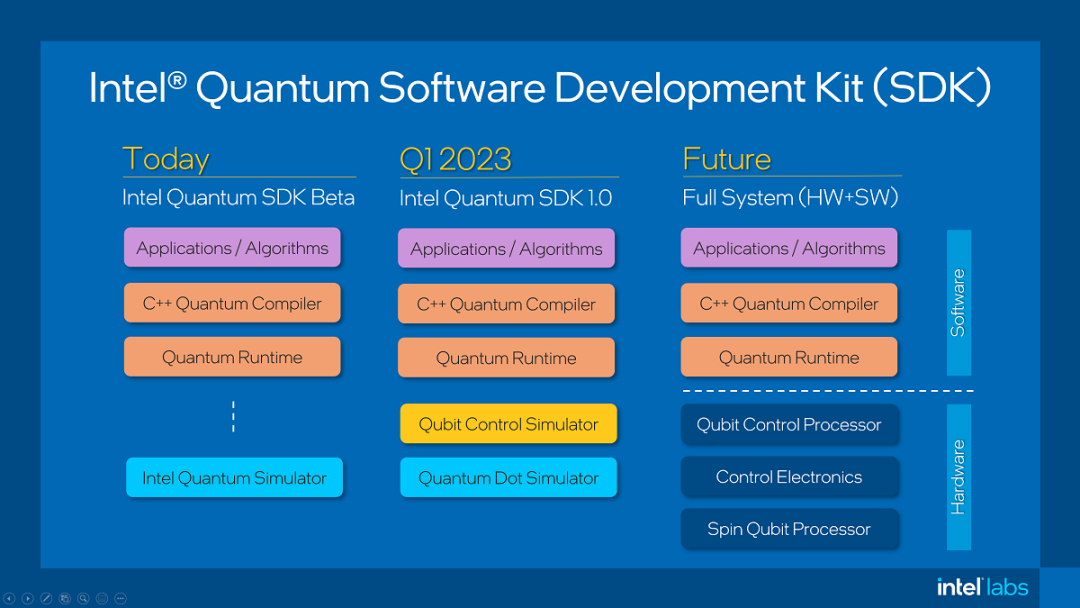

三、 軟硬件協同開發的必然趨勢

面對上述挑戰,傳統的“軟件框架先行,硬件適配跟進”的模式已顯乏力。計算機視覺應用的深入發展,正催生著軟硬件協同設計的新范式:

- 硬件感知的軟件優化:深度學習框架越來越多地集成硬件特性感知的優化器。例如,自動生成針對特定芯片微架構高度優化的計算內核,或者根據硬件的內存布局自動調整數據排布。

- 軟件驅動的硬件設計:硬件設計(如新型AI芯片)越來越多地以主流深度學習框架所定義的計算模式和算子為核心進行定制,設計專用的計算單元、內存系統和互聯架構,從根源上提升關鍵視覺任務(如卷積、注意力機制)的執行效率。

- 統一中間表示與編譯器棧:如MLIR(Multi-Level IR)等項目的興起,旨在構建一個可擴展的編譯器基礎設施,在高層框架計算圖與底層硬件指令之間建立多層中間表示,使軟硬件之間的優化與映射更加系統化和自動化。

結論

計算機視覺應用的邊界正不斷拓展,其對性能、精度、延遲和能效的嚴苛要求,構成了對深度學習框架的全面考驗。這一挑戰的本質,是推動深度學習系統從“軟硬件分離”走向“軟硬件協同”。未來的深度學習框架,將不再是純粹的軟件抽象層,而是演變為一個連接算法創新與硬件算力的智能、自適應橋梁。只有通過軟件與硬件的深度融合與協同創新,才能充分釋放計算潛力,支撐起下一代更強大、更普及的計算機視覺應用。

如若轉載,請注明出處:http://m.jisukj.com/product/40.html

更新時間:2026-02-20 17:00:37